一.Web目录扫描思路

1.网站目录和敏感文件扫描

网站目录和敏感文件扫描是网站测试中最基本的手段之一。如果通过该方法发现了网站后台,可以尝试暴库、SQL注入等方式进行安全测试;如果发现敏感目录或敏感文件,能帮我们获取如php环境变量、robots.txt、网站指纹等信息;如果扫描出了一些上传的文件,我们甚至可能通过上传功能(一句话恶意代码)获取网站的权限。

2.原理

在Web目录扫描中,字典是非常重要的,一个好的字典能帮助我们的程序更好地发现漏洞和目标。那么,如何通过 Python 代码实现Web目录扫描呢?或者Web目录扫描器的原理是什么呢?

其原理是通过请求返回的信息来判断当前目录或文件是否真实存在。网站后台扫描工具都是利用目录字典进行爆破扫描,字典越多,扫描到的结果也越多。常见的Web目录扫描工具包括:御剑1.5、DirBuster、Dirsearch、Webdirscan、Cansina、Dirmap等。涉及的常用功能包括:能使用字典、支持纯爆破、并发引擎、能爬取页面动态生成字典、能fuzz扫描、能自定义请求(代理)、自定义响应结果及响应状态等。

3.工具介绍

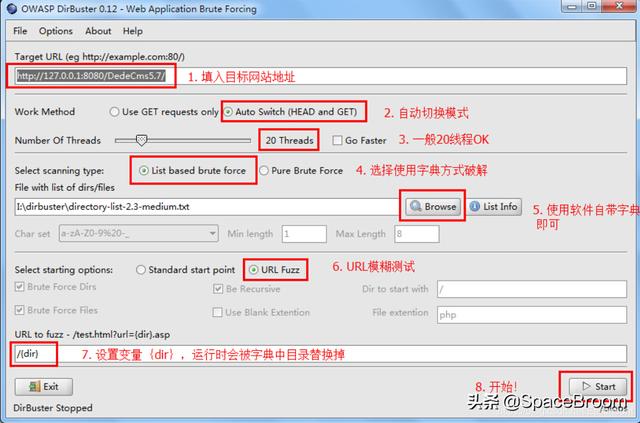

DirBuster

Kali Linux提供的目录扫描工具DirBuster支持全部的Web目录扫描方式。它既支持网页爬虫方式扫描,也支持基于字典暴力扫描,还支持纯暴力扫描。该工具使用 Java 语言编写,提供命令行(Headless)和图形界面(GUI)两种模式。其中,图形界面模式功能更为强大。用户不仅可以指定纯暴力扫描的字符规则,还可以设置以URL模糊方式构建网页路径。同时,用户还对网页解析方式进行各种定制,提高网址解析效率。

御剑

御剑系列的web工具一直是比较顺手的工具。这款御剑也是很好用的网站后台扫描工具,图形化页面,使用起来简单上手,因此也被大多数人所喜好。其作者可能是“御剑孤独”。

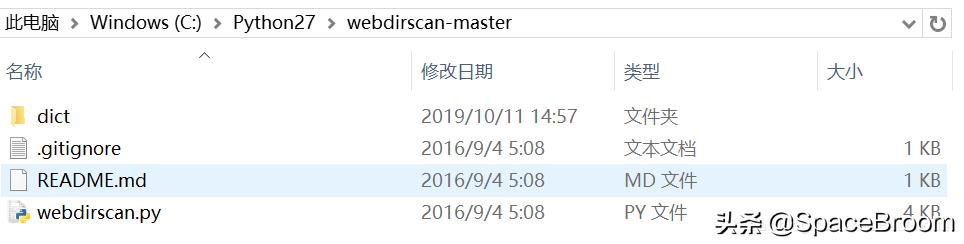

Webdirscan

webdirscan是一个很简单的 多线程 Web目录扫描工具,它是使用Python语言编写的,主要调用了requests第三方库实现。大家可以看看它Github上面的代码,和本篇博客原理较为相似。

源代码:

我们将代码下载至本地,再进行扫描目标网站。

将CMD命令行打开,进入webdirscan路径下,指定扫描任务。

python webdirscan.py 目标网站

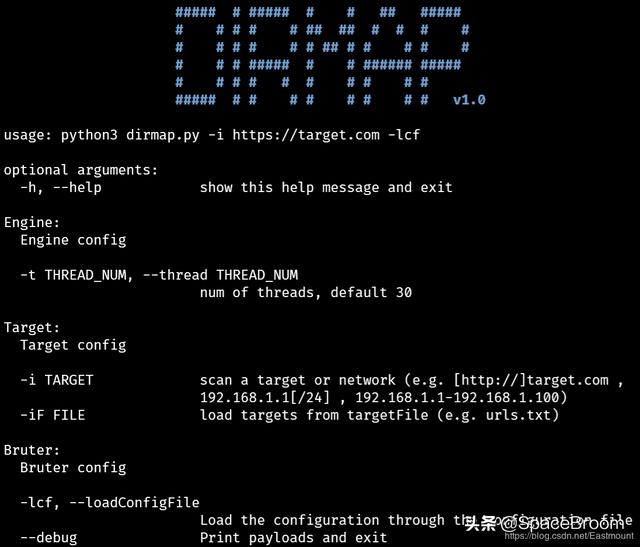

Dirmap

它是一个高级web目录扫描工具,功能将会强于DirBuster、Dirsearch、cansina、御剑。详见:

注意:工具的使用方法这里就不进行详细介绍了,希望读者下来自行学习,本文主要分享Python代码是如何实现Web目录扫描的。

二.Python构建Web目录扫描器

该程序主要实现以下3个功能:

判断Web目录或文件是否存在。通过requests发送请求实现,获取status_code状态码,状态码200表示成功。

通过读取文件后去 asp、aspx、jsp、php 常见目录,对其进行扫描。

由于很多安全产品能识别出你的恶意攻击请求,这里需要设置多线程调用,从而避免安全软件识别。

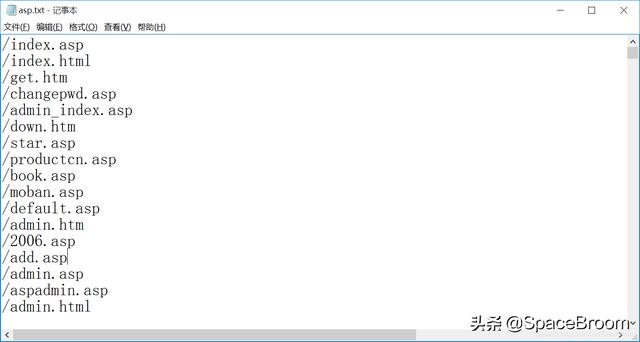

下面是Python实现Web目录扫描的代码,其中本地存在一个 asp.txt 文件(源自御剑),涉及了常见的网站目录。如下图所示:

完整代码:

# -*- coding: utf-8 -*-import requestsfrom Queue import Queueimport sysimport threading#多线程实现Web目录扫描class DirScan(threading.Thread): def __init__(self, queue): threading.Thread.__init__(self) self._queue = queue def run(self): #获取队列中的URL while not self._queue.empty(): url = self._queue.get() #print url try: headers = { "User-Agent": "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.84 Safari/537.36" } #发送请求 r = requests.get(url=url, headers=headers, timeout=8) #Web目录存在 if r.status_code == 200: #print '[*] ' + url sys.s td out.write('[*] %s\n' % url) except Exception, e: #print e pass#定义队列及放入URLdef start(url, ext , count): queue = Queue() f = open('%s.txt' % ext, 'r') for i in f: queue.put(url + i.rstrip('\n')) #多线程 threads = [] thread_count = int(count) for i in range(thread_count): threads.append(DirScan(queue)) for t in threads: t.start() for t in threads: t.join()#主函数if __name__ == '__main__': url = '#39; ext = 'asp' count = 10 start(url, ext, count)

作者通过浏览器搜索 “inurl:asp”,寻找某网站为例,接着调用程序获取它的目录。

其扫描结果如下图所示,通过访问这些链接发现它们是真实存在的。

写到这里,一个简单的Web目录扫描器就实现了,希望对大家有所帮助 。后续如果将我们的程序扩展到BurpSuite工具,就能更好地进行抓包分析及安全测试,你可以去试试~

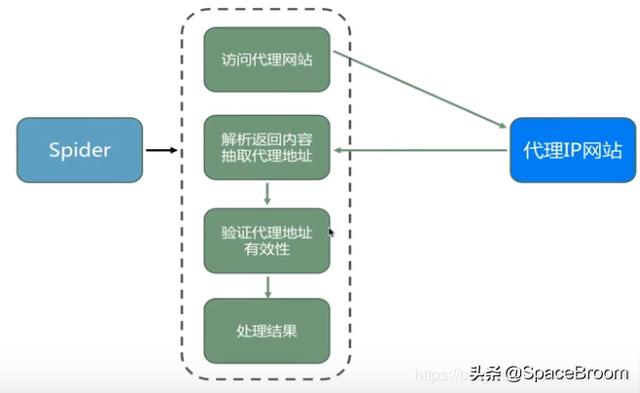

三.ip代理池

某些网站会对我们发送的请求进行有效拦截,这里可以尝试设置一个ip代理池,无论是网络爬虫还是请求发送,都能很好地解决这些问题。下面简单讲解一个获取IP代理的代码,但遗憾的是,作者想把它移植到上面那段代码中,但验证的IP地址多数无法访问,导致失败。

国内IP代理网站为:

其基本思路如下,通过Python爬虫获取IP地址、端口和协议类型,其代码的基本思路如下:

下面是对应的HTML源代码,需要抓取的是tr值,每行代表一个IP地址。

完整代码:

# -*- coding:utf-8 -*-import requestsimport refrom bs4 import BeautifulSoup as bsimport telnetlib#爬取数据def proxy_spider(): #设置请求 headers = {'User-Agent' : 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.102 Safari/537.36'} url = '#39; r = requests.get(url=url, headers=headers) print r #解析 通过re.compile('|[^odd]')解析奇数和偶数行 soup = bs(r.content, 'lxml') datas = soup.find_all(name='tr', attrs={'class': re.compile('|[^odd]')}) for data in datas: soup_proxy_content = bs(str(data), 'lxml') soup_proxys = soup_proxy_content.find_all(name='td') ip = str(soup_proxys[1].string) port = str(soup_proxys[2].string) types = str(soup_proxys[5].string) #print ip, port, types #判断IP地址是否存活 proxy = {} proxy[types.lower()] = '%s:%s' % (ip, port) #proxy_check(ip, port, types) proxy_telnet(ip, port, types)#获取能成功使用的代理ip内容 调用requests代理访问方法def proxy_check(ip, port, types): proxy = {} proxy[types.lower()] = '%s:%s' % (ip, port) #proxy = {'http':'119.254.84.90:80'} try: r = requests.get('#39;, proxies=proxy, timeout=6) #print r.text ip_content = re.findall(r"\[(.*?)\]", r.text)[0] if ip == ip_content: print proxy except Exception, e: print e pass#检测IP地址是否存活def proxy_telnet(ip, port, types): proxy = {} proxy[types.lower()] = '%s:%s' % (ip, port) try: telnetlib.Telnet(ip, port, timeout=2) print 'True:', proxy except: print 'False:', proxy proxy_spider()

输出结果如下图所示,IP地址和端口成功抓取,但是很多无法使用,读者可以自行试试。

获取IP地址之后,通过如下设置可以使用代理IP地址进行访问。 proxy = {‘http’:‘119.254.84.90:80’}

r = requests.get(‘’, proxies=proxy, timeout=6)

四.总结

希望这篇文章对你有所帮助,这是Python网络攻防非常基础的一篇博客,后续作者也将继续深入学习,制作一些常用的小工具供大家交流。作者B站的视频推荐几乎都是网络安全和Python编程,这个算法写得不错,最近挤空闲的时间看了100多部视频。Python攻防之弱口令、字典暴库还在撰写中,论文汇报的PPT也快100页了,接下来需要学会精简和总结。种一棵树最好的时间是十年前,其次是现在,忙点好,一起加油。